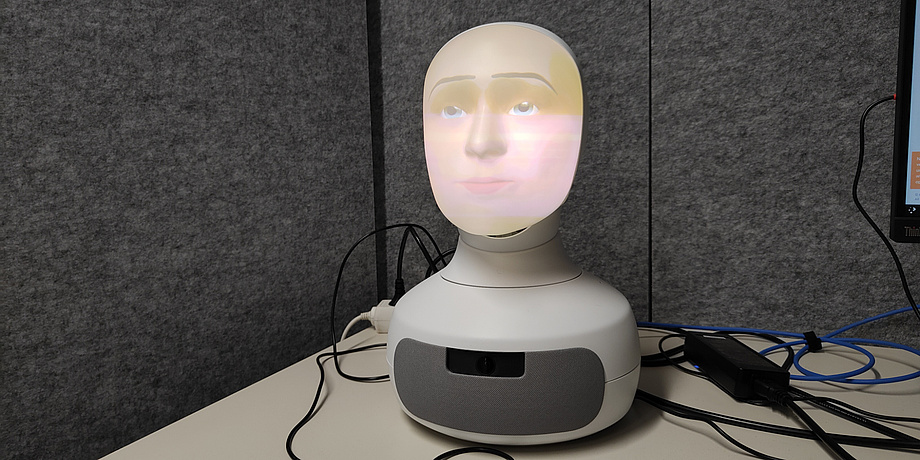

Eine konkrete Antwort auf die gestellte Frage, dazu die passende Mimik und der natürlich wirkende Blick auf die fragestellende Person gerichtet – auch wenn der Kopf auf dem Tisch eindeutig als Roboter zu erkennen ist, verhält er sich auffallend menschlich. Genau das ist auch eine der Eigenschaften, die der Furhat genannte Social Robot besitzen soll. Entwickelt wurde er ursprünglich an der Königlich Technischen Hochschule (KTH) in Schweden, mittlerweile ist mit Furhat Robotics eine eigene Firma daraus entstanden. Neben seinen kommerziellen Einsatzmöglichkeiten, etwa als Flughafen-Guide, Sprachlehrer*in oder unvoreingenommene*r Personalvermittler*in, ist er besonders im Forschungsbereich sehr gefragt – unter anderem am Institut für Signalverarbeitung und Sprachkommunikation der TU Graz, die über das Universitätsnetzwerk Unite! eng mit der KTH verbunden ist.

„Schon der ursprüngliche Gedanke hinter Furhat war die Interaktion: Wie spreche ich mit dem Roboter, wie reagiert er darauf? Mit diesen ersten Ideen wollten die Erfinder wissenschaftliche Hypothesen testen“, erklärt Barbara Schuppler vom Institut für Signalverarbeitung und Sprachkommunikation. Die Forschung mit Furhat geht mittlerweile in zahlreiche Richtungen: Die einzelnen Komponenten wie Mimik, Gestik, Sprachmelodie und rund 200 verschiedene Sprachmodelle in etwa 40 Sprachen sowie einigen regionalen Dialekten bieten nicht nur viele Möglichkeiten zur Erforschung der Mensch-Roboter-Interaktion, sondern auch in der Sprachforschung und -erkennung, in der Lernbetreuung und im therapeutischen Bereich.

Die menschlichen Signale erkennen

Ein großer Fokus liegt darauf, dass der Roboter die menschlichen Signale des Gegenübers erkennt, um daraus abzuleiten, wann es Zeit zu sprechen ist. „Da geht es um das Miteinander. Furhat schaut die Person an, die spricht, und wenn er etwa mit zwei Personen redet, wechselt er mit dem Blick hin und her. Er ist da sehr aufmerksam. Mittlerweile ist es möglich, seine Emotionen an den Gesprächskontext anzupassen“, sagt Barbara Schuppler. Auch das Feedback von Furhat, während das Gegenüber spricht, ist ein Teil des Miteinanders und Thema der Diplomarbeit von Michael Paierl. Er will dem Roboter beibringen, zum richtigen Zeitpunkt und mit der richtigen Sprachmelodie ein „Hmm“ oder „Mhm“ oder Ähnliches von sich zu geben, damit sich ein Gespräch noch natürlicher anfühlt.

Denn auch wenn wir uns dessen oft nicht bewusst sind, Menschen haben das Bedürfnis, irgendeine Art von Rückmeldung zu bekommen, wenn sie gerade etwas sagen – selbst wenn sie zu dem Zeitpunkt noch keine Antwort erwarten. Sie möchten einfach nur mitbekommen, dass sie verstanden werden. Gerade im Bereich Lernbetreuung, wenn gewisse Inhalte gemeinsam mit dem Social Robot erarbeitet werden, sind solche passenden Zwischenreaktionen wichtig. „Nehmen wir an, der Roboter stellt die Frage, wie das Gravitationsfeld funktioniert und die Schülerin oder der Schüler beginnt zu erklären. Da braucht es ein System, das während der Erklärung ein Feedback zum Ausdruck bringt“, sagt Michael Paierl.

Von Details zu einer gesamten Mimik

Um dieses System umzusetzen, untersucht er Video-Aufnahmen von Menschen, die miteinander sprechen, um daraus die akustischen Eigenschaften zu extrahieren, sie zu analysieren und ein Modell zu erstellen, damit Furhat diese Art der Interaktion lernt. Wenn Furhat selbst etwas erzählt, ist es bereits jetzt recht gut möglich, die Sprachintention und den mimischen Kontext mitzuverfolgen, da an der KTH und bei Furhat Robotics sehr viel an seiner Mimik geforscht worden ist. Dafür nahmen die Entwickler*innen verschiedene relevante Detailbereiche des Gesichts unter die Lupe – zum Beispiel Augenbrauenränder, Lippen oder Wangen – und brachten dort reflektierende Punkte an, um deren Positionsänderungen während verschiedener Konversationen zu untersuchen.

„Besonders die Augenbrauen und die gesamte Augenpartie gehen ganz stark mit der Sprachmelodie mit, wenn wir eine Frage stellen, eine Pause machen und nachdenken, ernst oder laut werden. Das spiegelt sich alles oben bei den Augen wider“, sagt Barbara Schuppler. Wenn es darum geht, was gesprochen wird, ist die Mundpartie der relevante Mimikbereich. Und so gibt es verschiedene Ebenen der Kommunikation, die sich in verschiedenen Bereichen des Gesichts widerspiegeln und die Furhat möglichst realistisch abbilden soll.

Ein Gesicht aus mehreren Ebenen

Diese Abbildung läuft über einen Projektor, der innen in der Rückseite des Kopfes eingebaut ist und die Gesichtszüge auf das halbtransparente Gesicht projiziert. Das funktioniert über mehrere Ebenen, sogenannte Layer. Der hinterste Layer ist das Gesicht selbst, Augen, Augenbrauen, Lippen, Wangen oder die Stirn haben eigene Layer. Im Gegensatz zu Robotern, bei denen die Mimik durch kleine Motoren unter einer flexiblen Gesichtsoberfläche gesteuert wird, ist der Ausdruck Furhats dadurch wesentlich dynamischer und natürlicher. So blicken die Augen nicht starr ins Leere, sondern können dank Gesichtserkennung das Gegenüber wirklich anschauen und sie bleiben laufend in Bewegung – wie bei einem Menschen eben auch.

Mit einer Einschränkung muss man bei einer Unterhaltung mit Furhat noch umgehen. Die Spracherkennung und die Sprachsynthese sind aufgrund der dafür notwendigen Hardware zu großen Anbietern wie Google oder Amazon ausgelagert. Das erweitert zwar das Stimm- und Sprach-Repertoire, doch trotz der großen Hardwarekapazitäten kommt eine Antwort mit einer etwas unnatürlichen Verzögerung. Wenn zusätzlich noch ein Large Language Model im Hintergrund läuft, um so die Bandbreite an Gesprächsthemen zu vergrößern, kann es einige Sekunden dauern, bis Furhat antwortet. Um das zu vermeiden, ist das Themenfeld, über das man sich unterhalten kann, vorab lokal ausprogrammiert und Furhats Antwortmöglichkeiten beschränken sich darauf.

Dialekt als Stolperstein

Somit ist der Einsatz als Gesprächspartner*in für gezielte Themenbereiche gut umsetzbar, ein spontaner Tratsch über Gott und die Welt muss vorerst aber noch etwas warten – zumindest wenn es ein Gespräch mit einem Roboter sein soll, das sich wie eines mit einem Menschen anfühlt. Und wer sich in einem speziellen österreichischen Dialekt mit Furhat unterhält, könnte trotz eingeschränkten Themengebiets ebenfalls auf ein paar Schwierigkeiten stoßen. Standard-Deutsch und Englisch liefern die besten Ergebnisse, bei Dialekten mit einer geringen Datenbasis, wie etwa verschiedenen österreichischen Varianten, kommt die Spracherkennung an ihre Grenzen. An einer besseren Erkennung trotz weniger Daten forscht Barbara Schuppler aber ebenfalls. Vielleicht kommt das in Zukunft Furhat zugute.

Sie möchten die aktuellen Stories, News, Forschungsgeschichten, Interviews oder Blogbeiträge der TU Graz direkt auf Ihr Smartphone oder in Ihren E-Mail-Eingang erhalten? Abonnieren Sie kostenfrei den TU Graz-Telegram-Newsletter.